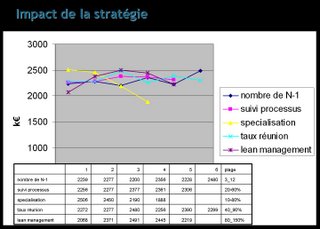

La première slide montre le type de résultats que l'on obtient sur l'analyse simple des leviers stratégiques. Les résultats sont en k€, correspondant à la valeur produite par l'exécution des processus. Je reviendrai sur le type de données produite par la simulation lorsque j'aurais des résultats plus stables.

La première slide montre le type de résultats que l'on obtient sur l'analyse simple des leviers stratégiques. Les résultats sont en k€, correspondant à la valeur produite par l'exécution des processus. Je reviendrai sur le type de données produite par la simulation lorsque j'aurais des résultats plus stables.Ce qu'on peut retenir de ces premiers résultats:

- les leviers stratégiques ont un effet significatif sur la transmission d'information qui se voit sur les résultats économiques,

- l'optimisation est pertinente: il existe des optimum locaux

- Il reste du travail à faire pour produire des résultats convaincant d'un point de vue statistique !

Sur ce dernier point, j'évalue à un facteur mille l'augmentation de temps de calcul pour produire des expérimentations vraiment satisfaisante (cf. le message précédent)

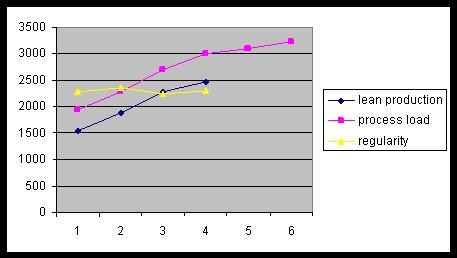

En revanche, l'expérimentation avec les scénarios (ce qui permet de faire varier la charge de travail fournie à l'entreprise) produit des résultats logiques (plus il y a de charge, plus on crée de valeur), ce qui est une indication que le simulation est cohérente.

Il a fallu de gros efforts pour arriver là ! Un modèle un peu trop naïf d'ordonnancement produit facilement des résultats contre-intuitifs. En fait, la raison principale de la complexification du modèle SIFOA est la volonté d'obtenir un fonctionnement robuste de l'entreprise, qui repose sur une bonne réactivité et optimisation de l'allocation des ressources (agents & canaux).

Pour terminer ce message, je me suis amusé à simuler "un monde sans e-mail".

Ce type d’approche permet de donner une valeur (monétaire) au service de e-mail dans l’entreprise !

Dans cette première simulation, j'ai observé ce qui se passe si le canal email est remplacé par le courrier interne (essentiellement une augmentation de la latence):

- on observe 10% de baisse du revenu, ce qui est significatif (2045 vs 2277)

- Le canal ASYNC passe de 17% à 12%

- Augmentation répartie des autres canaux

Ce type de simulation est très encourageant. Nous avons une façon de trancher le débat entre les deux positions excessives que l'on entend souvent ("Le mail ne sert à rien d'un point de vue économique" ou "sans email aujourd'hui, l'entreprise s'arrête"). Notons que ce peut être les mêmes qui tiennent les deux sortes de propos, lorsqu'il faut payer la maintenance des serveurs dans le premier cas et lorsqu'il y a un virus dans le seconde cas :) La prochaine étape sera de simuler l'introduction du canal "instant messenging".

A suivre donc, avec une reprise à la fin de l'année.

Bonjour Yves,

RépondreSupprimerTu as calculé que le mail faisait diminuer la latence par rapport au papier: c'était sans doute prévisible.Question : est ce qu'une messagerie instantanée "évoluée", qui permette de structurer l'information ne permettrait pas d'obtenir une latence encore moindre?

Il y a un autre élément à prendre en compte : les effets pervers de l'email (chaque mode de communication en possède, j'en conviens).

Le mail renforce la verticalité des organisations et ne favorise pas les échanges transverses et "ouverts"; il est un outil utile pour les petites gens (souvent haut placés) qui gardent l'information ("l'information c'est le pouvoir"). Ce sujet, je pense mérite réflexion et peut constituer un input utile dans tes calculs d'efficacité des organisations.

Au plaisir de te voir continuer ce blog ! Olivier

Bonjour Olivier,

RépondreSupprimerle point n'était pas le calcul de la diminution de la latence du mail par rapport au papier (je suis d'accord, ca ne serait pas une surprise :)) mais plutot l'évaluation de l'impact de cette diminution (cf. mon message du jour : c'est cela qui fait débat).

Ta remarque sur la verticalité est ingéressante: il faudrait étudier les réseaux sociaux constitués par les mails. Cela existe peut-être, je vais me renseigner en poursuivant ma découverte de CMC.

A+

-- Yves

L'intérêt d'une modélisation générique des organisations ne m'apparaît pas encore clairement. Il me semble en effet que des facteurs d'ordre 1 dépendant des métiers influencent considérablement les réseaux sociaux. Peut-être puis-je aider en évoquant le cas des directions informatiques. La plupart des DSI présentent les tropismes classiques d'une bureaucratie (organisation centrée sur la tâche du processus) : grosses directions fonctionnelles et hyper-spécialisation. Le processus principal, qui consiste à construire de nouvelles fonctionnalités, nécessite la traversée de plusieurs U (U cahier des charges, U stratégie d'architecture, U développement, U tests, U exploitation, etc.) avec allers-retours dans H. Cette organisation souffre d'atroces latences, et d'une chute de productivité avec la taille du patrimoine applicatif. Elle n'est que récente. Il y a 10 ans, l'organisation était plutôt centrée sur le produit, les applications informatiques, c'est à dire des U autonomes et efficaces, mais une subsidiarité dont le prix était l'hétérogénité des solutions développées, au détriment de la sécurité et de l'intégration de l'ensemble (mot de passe à ressaisir, données distordues, ruptures d'automatismes dues à des incompatibilités). On a donc vu les DSI évoluer d'un modèle en boucles fermées (centré sur le produit) nà un modèle en boucles ouvertes (centré sur la tâche du process) pour des raisons d'homogénéité. Qu'aurait donc donner notre simulation générique ? En quoi peut-elle aider la DSI ? Cette analyse par pattern n'est-elle pas un modèle, certes plus frugal, mais permettant l'action, le changement ? Ici le changement serait de redonner un coup de balancier vers l'organisation en boucles fermées, tout en tirant parti des innovations techniques et méthodologiques pour gérer le problème crucial de l'interopérabilité (intégration et sécurité)... Au final un facteur d'ordre 1 qui préside à ce choix d'organisation est la capacité à réduire la complexité des interfaces entre applications, c'est à dire à standardiser le domaine métier (modèle de données partagé, fédération des jeux de tests) et les tuyauteries techniques (transfert de message, de fichiers ..).

RépondreSupprimerHope it helps.